Коллекция русского мата, классификатор токсичности и детоксификатор

Всё это недавно представили исследователи из Сколтеха совместно с МТС.

Классификатор основан на RoBERTa и работает он очень классно. Есть модели для русского (тык) и для английского (тык).

А вот детоксификатор иногда выдаёт странные перлы 🌚

P.S. Да, матерных корня всего 4, но различных форм там собрано больше 130 тысяч. Словообразование у нас очень богатое 💁♂️

Статья, GitHub, маты, блог

_______

Источник | #abstractDL

Всё это недавно представили исследователи из Сколтеха совместно с МТС.

Классификатор основан на RoBERTa и работает он очень классно. Есть модели для русского (тык) и для английского (тык).

А вот детоксификатор иногда выдаёт странные перлы 🌚

P.S. Да, матерных корня всего 4, но различных форм там собрано больше 130 тысяч. Словообразование у нас очень богатое 💁♂️

Статья, GitHub, маты, блог

_______

Источник | #abstractDL

This media is not supported in your browser

VIEW IN TELEGRAM

🔥WebGPT: теперь GPT-3 умеет гуглить лучше тебя

В OpenAI зафайнтюнили GPT-3 отвечать на вопросы, пользуясь поиском Bing, а получившиеся при этом ответы оказались качественнее, чем у людей.

Сначала они разработали простенький текстовый браузер, которым могла бы пользоваться GPT — там есть основные команды типа: кликнуть на ссылку, поскроллить, найти слово на странице, скопировать фрагмент и тд. Далее они при помощи людей собрали датасет из 6000 примеров использования этого браузера и дообучили на нём GPT-3 (language modeling). Затем они нагенерили этой же моделью датасет из 25к вопросов и вручную разметили их качество. На этой разметке они обучили ранжировщик ответов и использовали его для дальнейшей фильтрации.

В итоге, судя по human evaluations на датасете ELI5, людям чаще нравятся ответы нейронки, чем своих собратьев 💁♂️

P.S. На гифке пример того, как гуглит эта модель, отвечая на вопрос «How do neural networks work?»

Статья, блог

_______

Источник | #abstractDL

В OpenAI зафайнтюнили GPT-3 отвечать на вопросы, пользуясь поиском Bing, а получившиеся при этом ответы оказались качественнее, чем у людей.

Сначала они разработали простенький текстовый браузер, которым могла бы пользоваться GPT — там есть основные команды типа: кликнуть на ссылку, поскроллить, найти слово на странице, скопировать фрагмент и тд. Далее они при помощи людей собрали датасет из 6000 примеров использования этого браузера и дообучили на нём GPT-3 (language modeling). Затем они нагенерили этой же моделью датасет из 25к вопросов и вручную разметили их качество. На этой разметке они обучили ранжировщик ответов и использовали его для дальнейшей фильтрации.

В итоге, судя по human evaluations на датасете ELI5, людям чаще нравятся ответы нейронки, чем своих собратьев 💁♂️

P.S. На гифке пример того, как гуглит эта модель, отвечая на вопрос «How do neural networks work?»

Статья, блог

_______

Источник | #abstractDL

MinD-Vis: диффузия для чтения мыслей

Представлена диффузионная модель, которая умеет декодировать то, что видит человек по его мозговой активности (fMRI).

Сначала авторы обучили self-supervised модель для получения универсальных эмбеддингов мозговой активности (одинаковых для разных людей). Далее они взяли предобученную Latent Diffusion и добавили к ней cross-attention на эти мысленные репрезентации. После короткого файнтюна на 1.5к парах картинка-fMRI модель смогла полноценно декодировать то, что видит перед собой человек!

Данные для обучения и код выложены в открытый доступ, веса моделей дают по запросу.

Статья, GitHub, блог

_______

Источник | #abstractDL

Представлена диффузионная модель, которая умеет декодировать то, что видит человек по его мозговой активности (fMRI).

Сначала авторы обучили self-supervised модель для получения универсальных эмбеддингов мозговой активности (одинаковых для разных людей). Далее они взяли предобученную Latent Diffusion и добавили к ней cross-attention на эти мысленные репрезентации. После короткого файнтюна на 1.5к парах картинка-fMRI модель смогла полноценно декодировать то, что видит перед собой человек!

Данные для обучения и код выложены в открытый доступ, веса моделей дают по запросу.

Статья, GitHub, блог

_______

Источник | #abstractDL

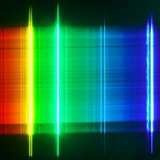

Как устроено пространство, в котором думают языковые модели?

Наша статья про анизотропию и внутреннюю размерность активаций трансформеров вышла в печать на EACL! В честь этого я подготовил небольшой хабр с её разбором.

Статья, хабр

_______

Источник | #abstractDL

@F_S_C_P

-------

поддержи канал

-------

Наша статья про анизотропию и внутреннюю размерность активаций трансформеров вышла в печать на EACL! В честь этого я подготовил небольшой хабр с её разбором.

Статья, хабр

_______

Источник | #abstractDL

@F_S_C_P

-------

поддержи канал

-------